新しい Nutanix CE 2.1 の投稿はこちらをどうぞ。

Nutanix Community Edition 2.0(CE 2.0、AOS 6.5.2 ベース)がリリースされたので、ESXi 上のネステッド Nutanix CE を構築してみます。ちなみに、ひとつ前のバージョンは Nutanix CE 2020.09.16(AOS 5.18 ベース)で、2年半ぶりくらいのリリースです。

Getting Started with Community Edition

今回の内容です。

- 構成イメージ

- 0. 物理マシン(ネストの外側)の vSphere 環境準備

- 1. ISO イメージ ファイルの入手

- 2. ポートグループの作成

- 3. Nutanix CE VM の作成

- 4. Nutanix CE のインストール

- 5. Prism Element へのログイン

- 6. CVM への SSH でのログイン確認

- 7. AHV への SSH ログイン

- 8. VMware Tools のインストール

構成イメージ

今回構築する環境の構成イメージです。(ファイルは こちら)

0. 物理マシン(ネストの外側)の vSphere 環境準備

今回の Nutanix CE VM を作成したネストの外側の物理マシンは、下記のような構成です。

- 物理 CPU: 12 論理コア(CVM には 4 vCPU)

- 物理メモリ: 32GB

- vSphere: ESXi 7.0 U3 / vCenter 7.0 U3

- データストア: ローカル SSD に作成した VMFS(容量は 1TB 弱)

1. ISO イメージ ファイルの入手

インストーラの ISO イメージ ファイルは、NEXT コミュニティのサイトからダウンロードします。

下記のファイルをダウンロードしておきます。

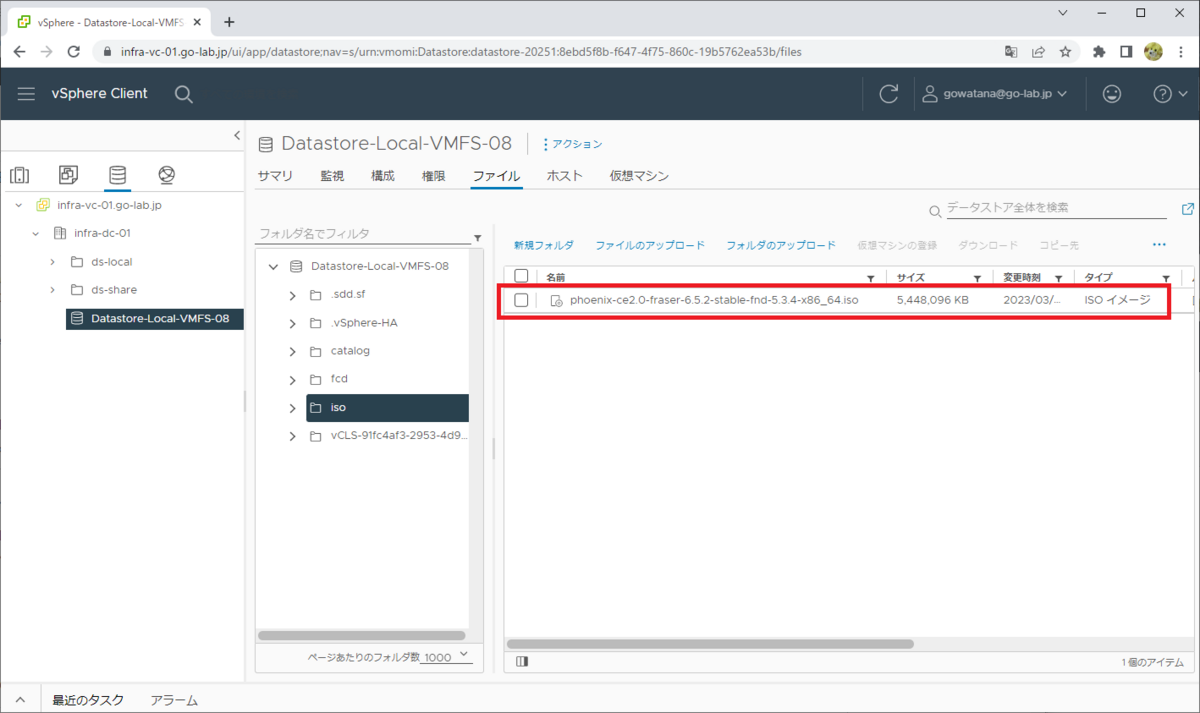

- phoenix-ce2.0-fraser-6.5.2-stable-fnd-5.3.4-x86_64.iso

ISO イメージ ファイルは、データストアにアップロードしておきます。

2. ポートグループの作成

ESXi の仮想スイッチに、ネステッド ハイパーバイザむけのポートグループを作成しておきます。

今回は、下記のような標準ポートグループを作成しました。

- ポートグループの名前: PG-Nested-Hypervisor

- VLAN ID: 20

このラボの Nutanix 管理ネットワークにあわせて VLAN ID 20 を設定してます。これは、Nutanix CE インストール後に AHV / CVM 側で VLAN を終端するように設定すれば、VLAN トランク設定(VLAN ID 4095 または 0-4094 など)に変更できます。

また、このポートグループではセキュリティ ポリシーも、ネステッド ハイパーバイザむけに設定変更しておきます。

- 無差別モード: 承諾

- 偽装転送: 承諾

3. Nutanix CE VM の作成

ESXi 上に、Nutanix CE をインストールする仮想マシンを作成します。

3-1. VM の作成

まず、AHV のベースとなる Linux ディストリビューションにあわせて、CentOS 7 の仮想マシンを作成します。まずは下記を選択しつつ、他はデフォルト設定で作成しておきます。

- 互換対象: ESXi 7.0 U2 以降(仮想マシン ハードウェア バージョン 19)

- ゲスト OS ファミリ: Linux

- ゲスト OS バージョン: CentOS 7 (64 ビット)

3-2. VM の設定変更

作成した VM の設定を調整していきます。

CPU の設定を変更します。

- CPU 数: 4

- ハードウェア アシストによる仮想化をゲスト OS に公開: ON

メモリの設定を変更します。とりあえずシステム要件の最小値を設定しますが、 これは前バージョンまでの CE 利用経験上、できるだけ多く割り当てたほうがよいです。

- メモリ:20GB

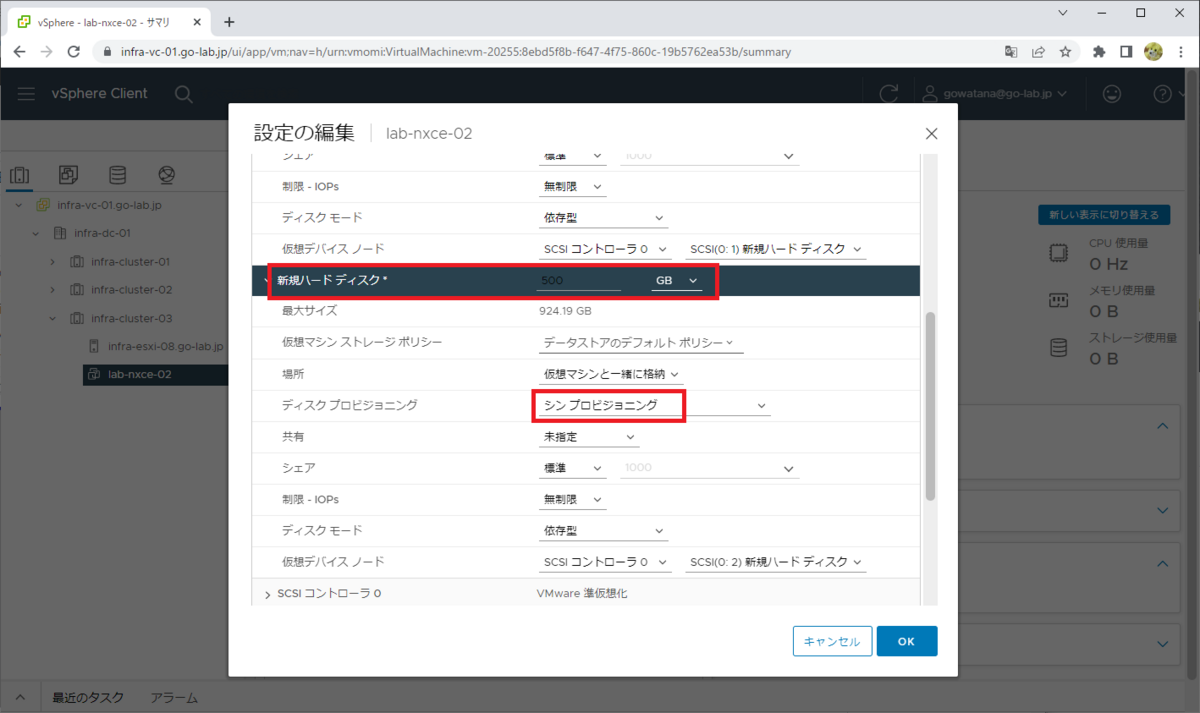

仮想マシンのハード ディスク(仮想ディスク)は、合計 3つ作成しておきます。これは、シン プロビジョニング でも大丈夫です。

- ハード ディスク 1: 32GB(ブート)

- ハード ディスク 2: 200GB(データ)

- ハード ディスク 3: 500GB(CVM と データ)

1つめのハード ディスクは、デフォルトで作成されるものを 32GB に変更するか、いったん削除して再作成します。

仮想マシンのハード ディスクは、「新規デバイス」→「ハード ディスク」で追加できます。

2つめのハード ディスクのパラメータを入力します。

- サイズ: 200GB

- ディスク プロビジョニング: シン プロビジョニング

同様に 3つめのハード ディスクも追加しておきます。「仮想デバイス ノード」のコントローラは、デフォルトの SCSI コントローラのままで大丈夫です。

- サイズ: 500GB

- ディスク プロビジョニング: シン プロビジョニング

仮想マシンのネットワーク アダプタには、ネステッド ハイパーバイザむけに作成したポートグループを割り当てます。

- ポートグループ: PG-Nested-Hypervisor

- パワーオン時に接続: オン

3-3. ISO イメージ ファイルの接続

データストアにアップロードしておいた Nutanix CE の ISO イメージ ファイルを、仮想マシンの CD/DVD ドライブに接続しておきます。

「データストア の ISO ファイル」を選択してから ISO イメージ ファイルのパスを選択して、「パワーオン時に接続」チェックボックスがオンになっていることを確認します。

3-4. disk.EnableUUID の設定

複数ノードの AHV でクラスタを構成する場合は、インストーラから仮想ディスクの ID を認識できるように、仮想マシンに disk.EnableUUID = true を設定します。

設定の様子については下記をどうぞ。

4. Nutanix CE のインストール

仮想マシンをパワーオンすると、ISO ブートによりそのままインストーラが起動されるるので、リモート コンソールを開いて操作します。

この環境では VMware Workstation Pro がインストールされているため、Workstation のリモート コンソールから vCenter Server に接続されていますが、通常は vSphere Client の Web コンソールか Remote Console から仮想マシンの画面を開きます。

しばらく待つと、下記のようなメニュー画面が表示されます。

今回は下記の構成にして、「Next Page」に進みます。

- Hypervisor は、AHV

- Disk Selection(ディスクの用途)は、とりあえず認識したまま。

- sda 32GB: H(Hypervisor Boot)

- sdb 200GB: D(Data)

- sdc 500GB: C(CVM Boot)

- CVM boot → 500GB の sdc)

- ネットワーク 設定を入力。AHV と CVM は同ネットワークに配置する。

- Host(AHV)の IP アドレス

- CVM の IP アドレス

- サブネット マスク

- デフォルト ゲートウェイ

- Nutanix クラスタの作成。今回はインストールと同時に 1-Node クラスタを作成する。

- Create single-node cluster?: オン

- DNS Server: CVM がインターネットアクセスするために名前解決する DNS サーバのアドレスを入力する。8.8.8.8 などでも OK。

- ここでクラスタ作成をスキップする場合は、あとで CVM で cluster create コマンドを実行してクラスタを作成します。

$ cluster -s <CVM の IP アドレス> --redundancy_factor=1 create

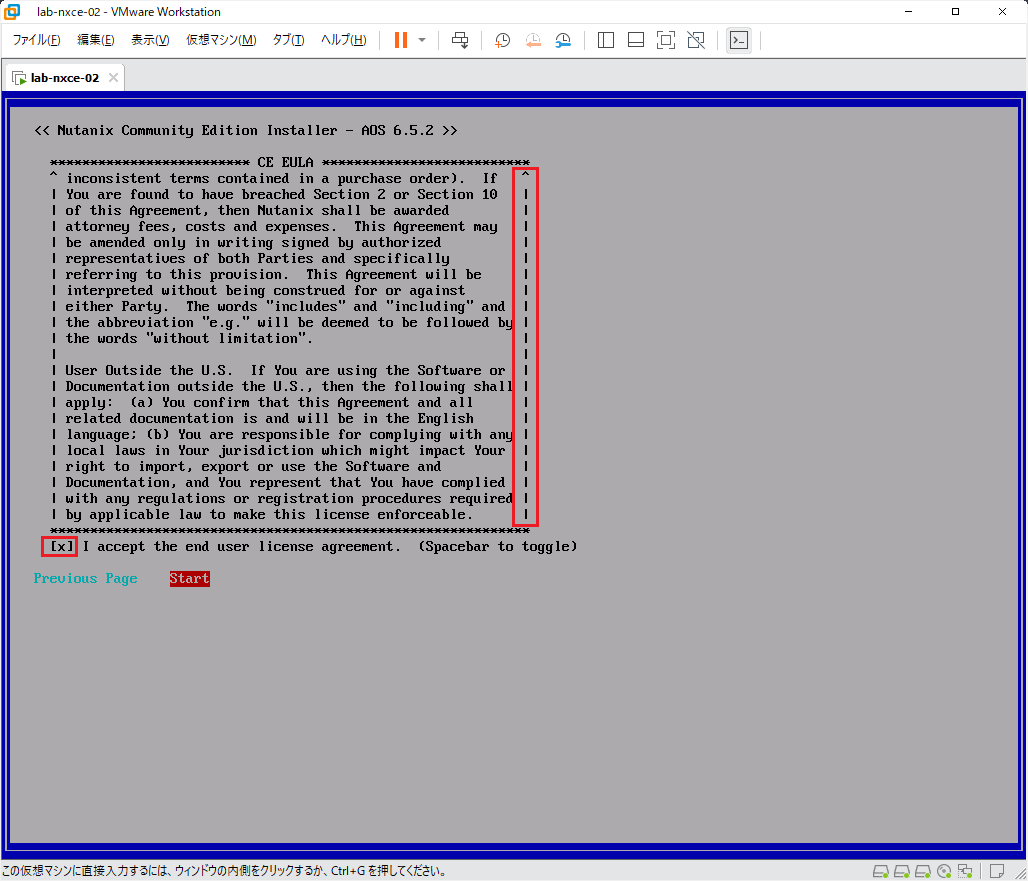

CE EULA を読んで、下までスクロールします。スクロールしておかないと次の画面でエラーになるので、「↓」や「Page Down」キーでからならず下まですすめておきます。

そして「I accept ~」チェックボックスをオンにして、「Start」で Enter キーを押します。

インストール処理が開始されるので、しばらく待ちます。

処理が終了すると、下記のようにメッセージが表示されるので、VM から ISO イメージを外します。

ISO イメージ ファイルを外すため、仮想マシンの「設定の編集」画面で、CD/DVD ドライブを「クライアント デバイス」に変更しておきます。

vSphere Client で画面更新すると、仮想マシンで CD-ROM ドアロックのメッセージが表示されるので、「質問への回答」をクリックします。

ここで必ず ISO イメージ ファイルを外しておきたいので、「はい」を選択して「回答」をクリックします。ちなみに、この回答を実施するまで仮想マシンはハングしているはずです。

「Y」を入力して Enter キーを押します。

再起動され、AHV が起動します。

AHV が起動された後、内部では Nutanix クラスタの作成処理が実行されるので、しばらく待ちます。環境により 10分 ~ 数十分くらいかかります。

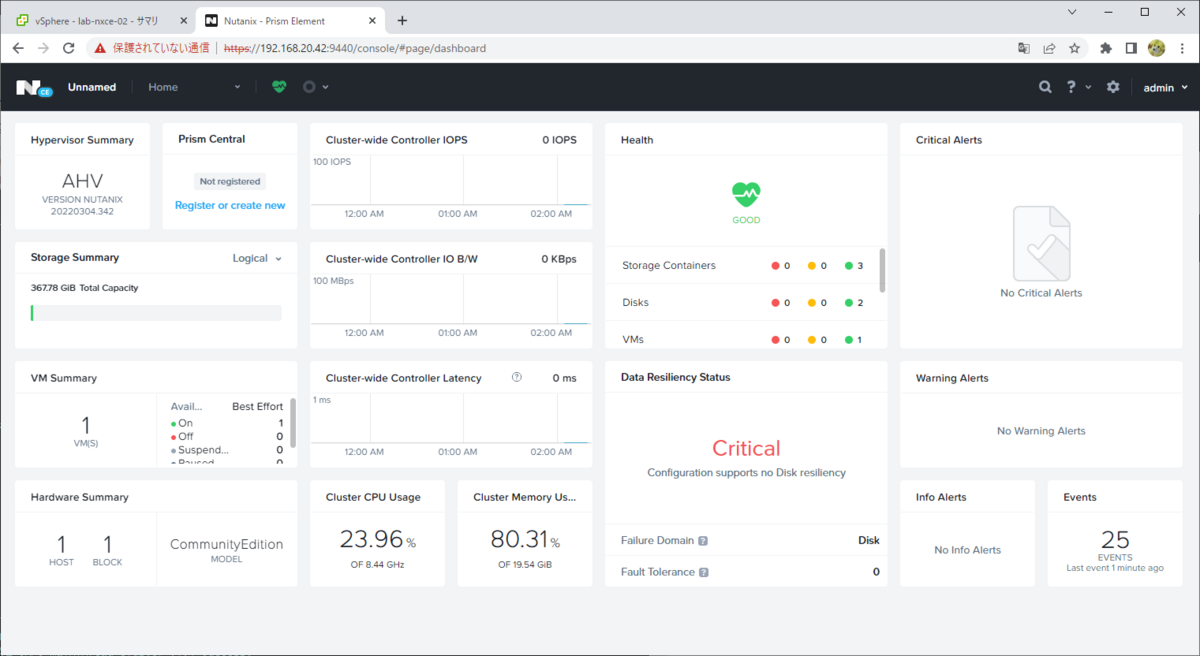

5. Prism Element へのログイン

Nutanix クラスタの作成が成功すると、Prism(Prism Element)にアクセスできるようになります。

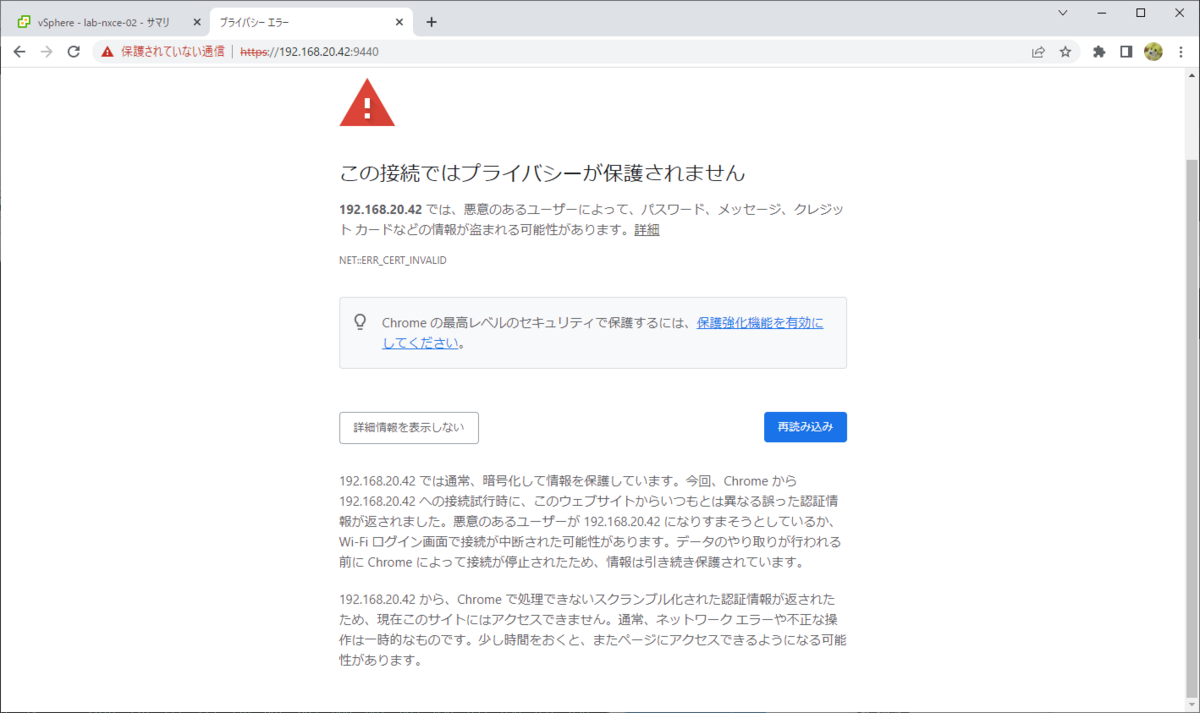

Web ブラウザから、「https://<CVM の IP アドレス>:9440」にアクセス(そしてブラウザの証明書エラーは無視)すると、Prism のログイン画面が表示されます。

Google Chrome でアクセスする場合は、「thisisunsafe」(this is unsafe)をキー入力して証明書エラーを無視します。

Prism の初回ログインのアカウントは下記です。

- ユーザ: admin

- パスワード: nutanix/4u

画面に従って、admin ユーザのパスワードを変更します。

画面に従い、Nutanix コミュニティの NEXT アカウントでログインします。ログインに失敗する場合は、CVM の DNS サーバ設定(/etc/resolv.conf ファイル)などが正しいか確認します。

これで、Prism にログインできるはずです。

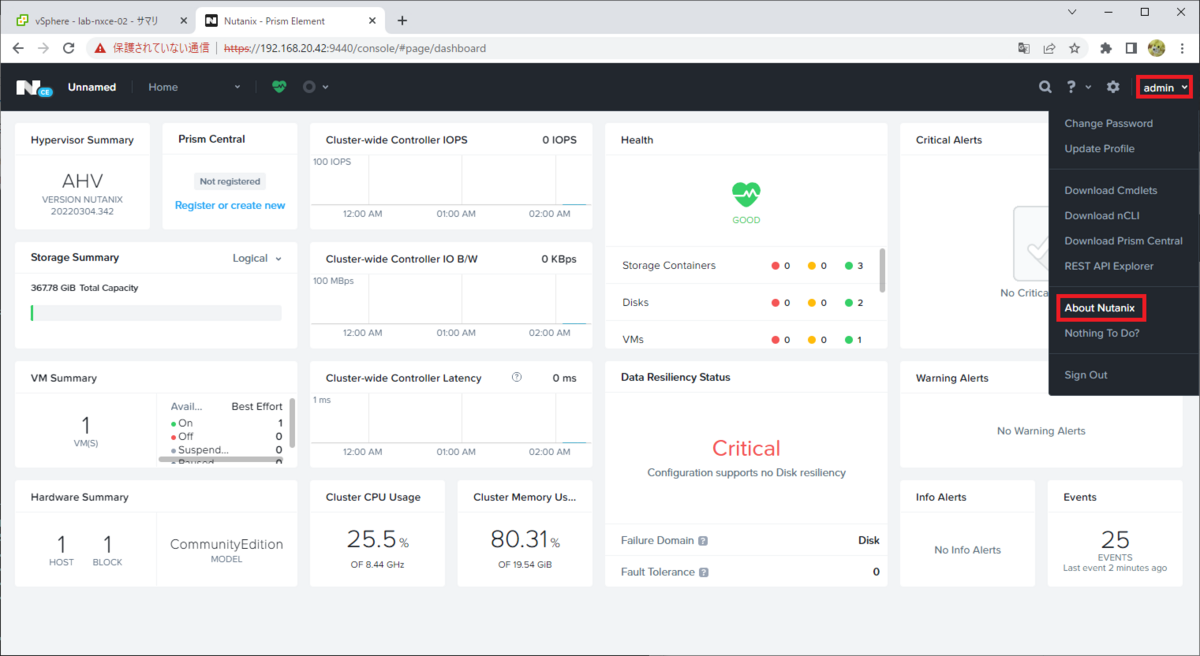

画面右上のユーザ名(admin)→「About Nutanix」を開くと・・・

AOS 6.5.2 ベースの CE がインストールされたことがわかります。

6. CVM への SSH でのログイン確認

CVM にも SSH ログインできます。デフォルトのログイン アカウントは下記です。Prism の admin ユーザでもログインできます。

- ユーザ: nutanix

- パスワード: nutanix/4u

genesis status で CVM で起動されている Nutanix 関連サービスの様子が確認できます。1-Node クラスタの作成が完了していると、下記のようにサービスが起動されています。

nutanix@NTNX-49ccf2f8-A-CVM:192.168.20.42:~$ genesis status 2023-03-03 17:16:19.903188: Services running on this node: acropolis: [27174, 27308, 27309, 27310] alert_manager: [25624, 25914, 25915, 25937] anduril: [32004, 32275, 32276, 32277, 32288] aplos: [30649, 30808, 30809, 30810] aplos_engine: [29879, 30090, 30091, 30092] arithmos: [25840, 26030, 26031, 26076] athena: [22379, 22615, 22616, 22617] cassandra: [19709, 19842, 19843, 19847, 20278] catalog: [26634, 26878, 26879, 26880, 26891] cerebro: [24839, 25005, 25006, 25032] chronos: [24940, 25132, 25133, 25176] cim_service: [25439, 25723, 25724, 25725, 25726] cluster_config: [29297, 29790, 29791, 29792, 29832] cluster_health: [616, 770, 771, 773, 776, 882, 883, 886, 887, 889, 890, 895, 896, 897, 898, 909, 910, 911, 917, 1037, 1038, 1056, 1057, 1064, 1065, 1079, 1080, 3516, 3517, 3518, 3519, 3520, 3521, 3522, 3523, 3524, 3525, 3532, 3540, 3551, 3560, 3638, 3647, 32640] curator: [24971, 25250, 25251, 25264] delphi: [31605, 31797, 31798, 31799, 31822] dynamic_ring_changer: [22139, 22225, 22226, 22232] ergon: [24474, 24718, 24719, 25017, 25023] flow: [31878, 32200, 32201, 32202, 32215] foundation: [] genesis: [2781, 3017, 3041, 3042, 15690, 15691, 15692, 15693] go_ergon: [24687, 24901, 24902, 24911] hera: [25325, 25616, 25617, 25618] ikat_control_plane: [18891, 18967, 18968, 18969] ikat_proxy: [18241, 18368, 18369, 18370] insights_data_transfer: [24445, 24572, 24573, 24577, 24578, 24579, 24580, 24581, 24582] insights_server: [22283, 22453, 22454, 22460] lazan: [31053, 31497, 31498, 31499] mantle: [22981, 23166, 23167, 23174] mercury: [1398, 1489, 1490, 1496] minerva_cvm: [29193, 29585, 29586, 29588, 29846] nutanix_guest_tools: [27417, 27626, 27627, 27748, 27815] pithos: [22164, 22280, 22281, 22304] placement_solver: [30718, 31195, 31196, 31197, 31220] polaris: [31558, 31703, 31704, 31717] prism: [25200, 25400, 25401, 25454, 25549, 25615] scavenger: [15276, 15419, 15420, 15421] secure_file_sync: [19010, 19222, 19223, 19224] security_service: [31711, 31980, 31981, 31982] ssl_terminator: [18977, 19119, 19120] stargate: [23846, 23975, 23976, 24042, 24043] sys_stat_collector: [17151, 17277, 17278, 17279] uhura: [27347, 27519, 27520, 28247] xmount: [15262, 15383, 15384, 15422] xtrim: [32125, 32623, 32624, 32625] zookeeper: [12182, 12230, 12231, 12232, 12241, 12259] nutanix@NTNX-49ccf2f8-A-CVM:192.168.20.42:~$

cluster status で、Nutanix クラスタ全体でのサービスの状態を確認できます。1-Node クラスタの作成が完了していると、下記のようにサービスが起動されています。

nutanix@NTNX-49ccf2f8-A-CVM:192.168.20.42:~$ cluster status

2023-03-03 17:18:11,732Z INFO MainThread zookeeper_session.py:191 cluster is attempting to connect to Zookeeper

2023-03-03 17:18:11,749Z INFO Dummy-1 zookeeper_session.py:625 ZK session establishment complete, sessionId=0x186a86c0169016a, negotiated timeout=20 secs

2023-03-03 17:18:11,753Z INFO MainThread cluster:2943 Executing action status on SVMs 192.168.20.42

The state of the cluster: start

Lockdown mode: Disabled

CVM: 192.168.20.42 Up, ZeusLeader

Zeus UP [12182, 12230, 12231, 12232, 12241, 12259]

Scavenger UP [15276, 15419, 15420, 15421]

Xmount UP [15262, 15383, 15384, 15422]

SysStatCollector UP [17151, 17277, 17278, 17279]

IkatProxy UP [18241, 18368, 18369, 18370]

IkatControlPlane UP [18891, 18967, 18968, 18969]

SSLTerminator UP [18977, 19119, 19120]

SecureFileSync UP [19010, 19222, 19223, 19224]

Medusa UP [19709, 19842, 19843, 19847, 20278]

DynamicRingChanger UP [22139, 22225, 22226, 22232]

Pithos UP [22164, 22280, 22281, 22304]

InsightsDB UP [22283, 22453, 22454, 22460]

Athena UP [22379, 22615, 22616, 22617]

Mercury UP [1398, 1489, 1490, 1496]

Mantle UP [22981, 23166, 23167, 23174]

VipMonitor UP [26434, 26435, 26436, 26437, 26439]

Stargate UP [23846, 23975, 23976, 24042, 24043]

InsightsDataTransfer UP [24445, 24572, 24573, 24577, 24578, 24579, 24580, 24581, 24582]

Ergon UP [24474, 24718, 24719, 25017, 25023]

GoErgon UP [24687, 24901, 24902, 24911]

Cerebro UP [24839, 25005, 25006, 25032]

Chronos UP [24940, 25132, 25133, 25176]

Curator UP [24971, 25250, 25251, 25264]

Prism UP [25200, 25400, 25401, 25454, 25549, 25615]

Hera UP [25325, 25616, 25617, 25618]

CIM UP [25439, 25723, 25724, 25725, 25726]

AlertManager UP [25624, 25914, 25915, 25937]

Arithmos UP [25840, 26030, 26031, 26076]

Catalog UP [26634, 26878, 26879, 26880, 26891]

Acropolis UP [27174, 27308, 27309, 27310]

Uhura UP [27347, 27519, 27520, 28247]

NutanixGuestTools UP [27417, 27626, 27627, 27748, 27815]

MinervaCVM UP [29193, 29585, 29586, 29588, 29846]

ClusterConfig UP [29297, 29790, 29791, 29792, 29832]

APLOSEngine UP [29879, 30090, 30091, 30092]

APLOS UP [30649, 30808, 30809, 30810]

PlacementSolver UP [30718, 31195, 31196, 31197, 31220]

Lazan UP [31053, 31497, 31498, 31499]

Polaris UP [31558, 31703, 31704, 31717]

Delphi UP [31605, 31797, 31798, 31799, 31822]

Security UP [31711, 31980, 31981, 31982]

Flow UP [31878, 32200, 32201, 32202, 32215]

Anduril UP [32004, 32275, 32276, 32277, 32288]

XTrim UP [32125, 32623, 32624, 32625]

ClusterHealth UP [616, 770, 771, 773, 776, 882, 883, 886, 887, 889, 890, 895, 896, 897, 898, 909, 910, 911, 917, 1037, 1038, 1056, 1057, 1064, 1065, 1079, 1080, 3516, 3517, 3518, 3519, 3520, 3521, 3522, 3523, 3524, 3525, 3532, 3540, 3551, 3560, 3638, 3647, 32640]

2023-03-03 17:18:14,109Z INFO MainThread cluster:3104 Success!

nutanix@NTNX-49ccf2f8-A-CVM:192.168.20.42:~$

7. AHV への SSH ログイン

AHV には SSH ログインできます。デフォルトのログイン アカウントは下記です。

- ユーザ: root

- パスワード: nutanix/4u

8. VMware Tools のインストール

ESXi でのネステッド環境なので、Nutanix CE の AHV(CVM ではなく)に VMware Tools をインストールしておくと便利です。

AHV は CentOS ベースなので、open-vm-tools をインストールしたいところですが、RPM の依存関係の都合でインストールが難しそうなので、ESXi 同梱の tar.gz ファイルでインストールします。

今回インストールした VMware Tools は下記です。

- VMwareTools-10.3.24-18733423.tar.gz

まず vSphere Client から、Nutanix CE VM に VMware Tools の ISO イメージ ファイルをマウントしておきます。

Nutanix CE VM を右クリックして、「ゲスト OS」→「VMware Tools のインストール」をクリックします。

確認画面で「マウント」をクリックすると、仮想マシンの CD/DVD ドライブに VMware Tools の ISO イメージ ファイルがマウントされます。

AHV にログインして、ゲスト OS 側でも ISO イメージ ファイルをマウントします。今回は、/mnt ディレクトリにマウントします。

[root@NTNX-49ccf2f8-A ~]# mount /dev/cdrom /mnt/ mount: /dev/sr0 is write-protected, mounting read-only

tar.gz ファイルを展開します。

[root@NTNX-49ccf2f8-A ~]# tar zxvf /mnt/VMwareTools-10.3.24-18733423.tar.gz [root@NTNX-49ccf2f8-A ~]# cd vmware-tools-distrib/

デフォルト設定で、VMware Tools をインストールします。インストールが完了すると、ISO イメージ ファイルは、自動的にゲスト OS と仮想マシンからアンマウントされるはずです。

[root@NTNX-49ccf2f8-A vmware-tools-distrib]# ./vmware-install.pl --default

VMware Tools のサービスが起動されたことを確認します。

[root@NTNX-49ccf2f8-A ~]# /etc/init.d/vmware-tools status vmtoolsd is running [root@NTNX-49ccf2f8-A ~]# systemctl is-enabled vmware-tools vmware-tools.service is not a native service, redirecting to /sbin/chkconfig. Executing /sbin/chkconfig vmware-tools --level=5 enabled

vSphere Client では、Nutanix CE VM に AHV の IP アドレスが表示されるようになり、ゲスト OS のシャットダウンや再起動が実施できるようになります。

念のためここで AHV を再起動して、AHV と CVM が起動して Prism にアクセスできるようになることを確認しておくとよいと思います。

以上。